Tag: SEO

Mitte der 1990er Jahre fingen die allerersten Suchmaschinen im WWW an, das frühe Web zu systematisieren. Die Seitenbesitzer erkannten rasch den Wert einer lieblings Listung in den Suchergebnissen und recht bald entwickelten sich Organisation, die sich auf die Aufwertung qualifitierten.

In Anfängen ereignete sich der Antritt oft bezüglich der Transfer der URL der entsprechenden Seite in puncto verschiedenartigen Search Engines. Diese sendeten dann einen Webcrawler zur Prüfung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Internetseite auf den Web Server der Anlaufstelle, wo ein weiteres Softwaresystem, der allgemein so benannte Indexer, Infos herauslas und katalogisierte (genannte Wörter, Links zu diversen Seiten).

Die frühen Typen der Suchalgorithmen basierten auf Angaben, die dank der Webmaster sogar bestehen werden, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen im Internet wie ALIWEB. Meta-Elemente geben einen Überblick über den Content einer Seite, allerdings stellte sich bald herab, dass die Anwendung dieser Ratschläge nicht ordentlich war, da die Wahl der eingesetzten Schlagworte dank dem Webmaster eine ungenaue Vorführung des Seiteninhalts sonstige Verben vermochten. Ungenaue und unvollständige Daten in den Meta-Elementen vermochten so irrelevante Internetseiten bei speziellen Brauchen listen.[2] Auch versuchten Seitenersteller diverse Merkmale innerhalb des HTML-Codes einer Seite so zu beeinflussen, dass die Seite besser in den Serps gelistet wird.[3]

Da die damaligen Suchmaschinen sehr auf Aspekte dependent waren, die bloß in Händen der Webmaster lagen, waren sie auch sehr labil für Straftat und Manipulationen in der Positionierung. Um tolle und relevantere Vergleichsergebnisse in Suchergebnissen zu bekommen, mussten sich die Unternhemer der Suchmaschinen im Internet an diese Rahmenbedingungen adaptieren. Weil der Gelingen einer Recherche davon abhängt, wesentliche Ergebnisse der Suchmaschine zu den gestellten Keywords anzuzeigen, konnten ungünstige Vergleichsergebnisse darin resultieren, dass sich die User nach weiteren Entwicklungsmöglichkeiten wofür Suche im Web umblicken. Die Erwiderung der Suchmaschinen lagerbestand in komplexeren Algorithmen fürs Rang, die Gesichtspunkte beinhalteten, die von Webmastern nicht oder nur schwierig beherrschbar waren. Larry Page und Sergey Brin generierten mit „Backrub“ – dem Stammvater von Yahoo – eine Suchseiten, die auf einem mathematischen Suchalgorithmus basierte, der mit Hilfe der Verlinkungsstruktur Kanten gewichtete und dies in den Rankingalgorithmus eingehen ließ. Auch alternative Suchmaschinen überzogen in Mitten der Folgezeit die Verlinkungsstruktur bspw. gesund der Linkpopularität in ihre Algorithmen mit ein.

Bing

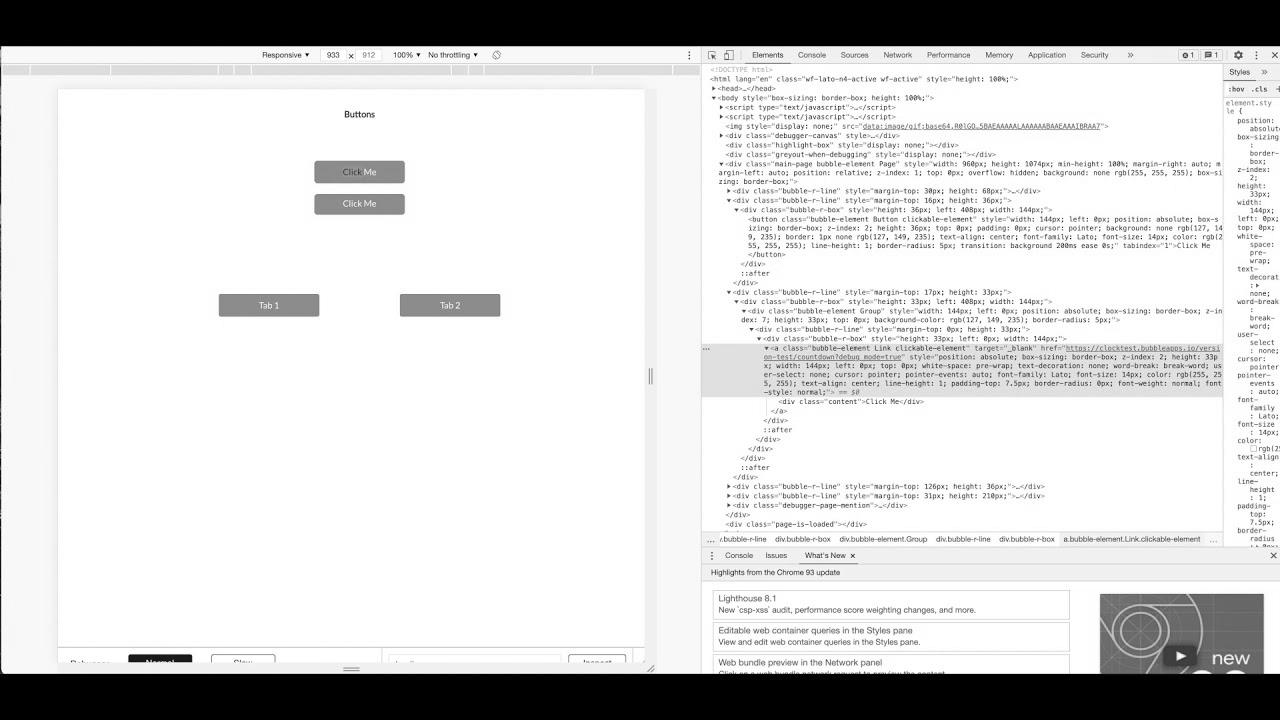

How does Google crawl your Bubble app? search engine optimisation greatest practices

How To Drive Visitors To Your Website With search engine optimization | Grow with Google

Meldung: Title Your YouTube Videos to Get Extra Views (YouTube web optimization Tutorial)

Nachricht: International web optimization Strategy (Get Began NOW)

Promote more on Etsy with Etsy search engine optimization | explained merely and rapidly for rookies

How To: Google Wealthy Snippet tutorial | Rich snippet meaning | Rich snippets web optimization instrument

Technical web optimization for eCommerce Website | eCommerce search engine optimisation Tutorial

How To RANK on Etsy – Etsy search engine marketing 2021 (5 Minute FIX!)

Thought Management & B2B search engine optimization Make a Perfect Pair